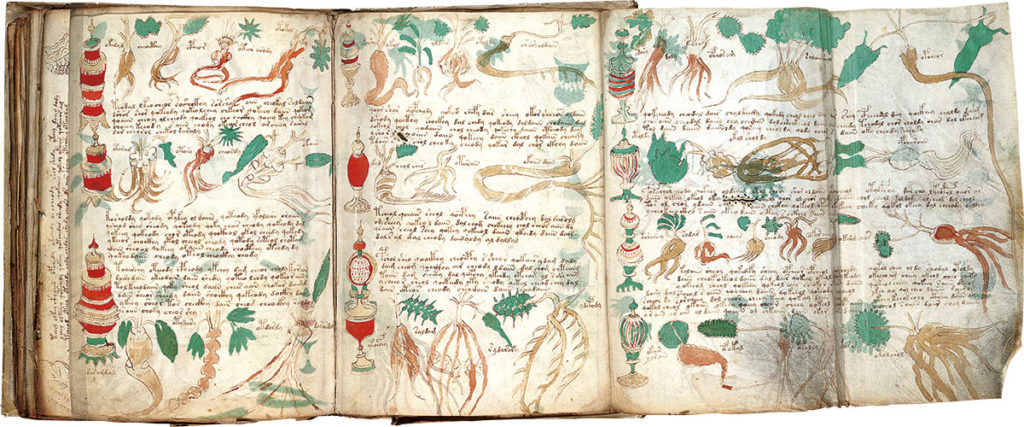

La utilización de información errónea o incorrecta con el fin de que los adversarios tomasen decisiones erróneas o que se aproximasen lo más posible a los intereses de aquellos que la emitían se ha utilizado de forma sistemática en los ámbitos militares y políticos desde hace siglos. Hoy en día, con la capacidad de transmisión de esta información personalizada y casi instantánea, esos actos de desinformación más allá de los objetivos tradicionales se centran en la población en general. Es cierto que la población está más o menos habituada a la propaganda, que se fundamentó principalmente gracias al desarrollo de los medios de comunicación durante el siglo XX, aunque los actos de desinformación se han generalizado y, por utilizar un término del siglo XXI, viralizado gracias a las redes sociales.

Desde la Guerra Fría, los actos de propaganda se han convertido en más difusos e indiscriminados y ya no se centra en un punto concreto. De hecho, en ocasiones, ya no son sólo agentes externos a un país los mayores interesados en difundir este tipo de información, también entidades locales buscan establecer narrativas que favorezcan sus propios intereses.

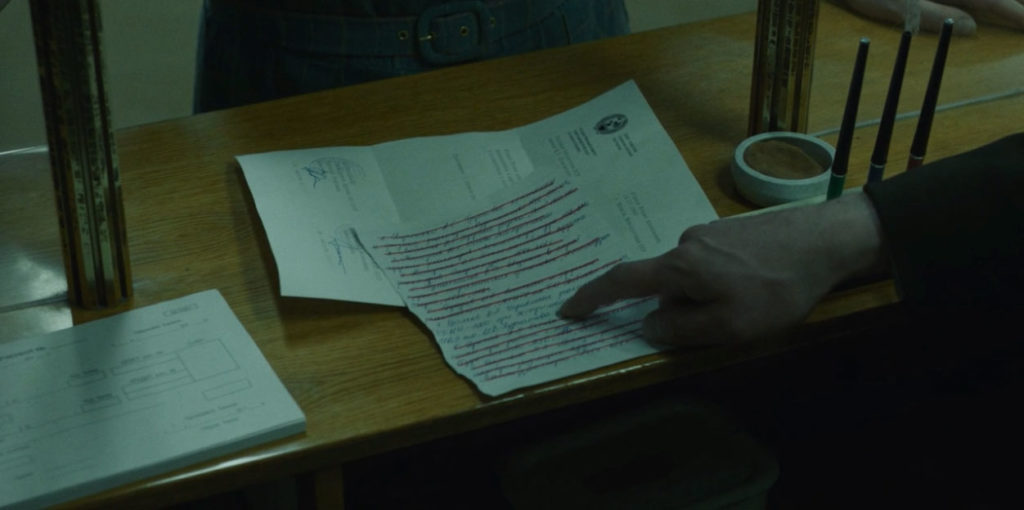

Las fake news, la «post-verdad», los hechos alternativos herederos de la forma de entender de hacer política del presidente Donald Trump y la desinformación son una tendencia ascendente que han obligado a los medios de comunicación y también a los profesionales de la información de establecer herramientas para tratar de refutar esas acciones.

Sin embargo, la aceptación o no de la información que se nos transmite no sólo depende de la fiabilidad de la fuente, sino también de nuestra disposición a ser susceptibles y tener un punto crítico sobre lo recibido atendiendo a nuestros propios sesgos cognitivos. Lamentablemente, nuestras fuentes de información actuales, muy fundamentadas en las redes sociales (que obviamente trabajan en ofrecernos información próxima a nuestra forma de opinar desechando prácticamente el resto) y nuestros círculos más próximos, no nos ayudan a recibir puntos de vista que refuten nuestras creencias previas.

Como bien se señala en el artículo Weaponization of the Future: Digital Warfare & Disinformation, este choque entre hechos verificados, opiniones interesadas o sesgadas, afecta ya a nuestro día a día de forma significativa. Baste poner el ejemplo de la propia evolución de la pandemia global y su tratamiento dentro de las redes sociales y las fuentes de información, en general, en ocasiones menoscaba los cimientos de la lucha contra ésta y puede llegar a afectar a la resolución satisfactoria de la misma.

Como las agencias de publicidad que buscan realizar perfiles de nuestros hábitos gracias a nuestra huella digital en Internet, los agentes de desinformación pueden utilizar las mismas técnicas gracias a esta misma parametrización. Además, el coste de recopilación y procesado de esta información es relativamente bajo, lo cual hace que la sofisticación de estas técnicas aumente de forma significativa a lo largo del tiempo.

Por supuesto que las personas se percatan de que las engañan y son más escépticos respecto a los contenidos que reciben por fuentes on-line no verificadas, sin embargo la complejidad de este engaño también aumenta mediante las GANS. En 2016, las sociedades occidentales no estaban preparadas respecto a estas tácticas de desinformación y se han desarrollado soluciones para combatirlas, pero esto es una batalla incierta puesto que el contrario también desarrolla contramedidas para atajar las armas que se puedan establecer contra este tipo de desinformación.

Deja un comentario